Прогресс шагает семимильными шагами: нейросети сочиняют музыку и даже предлагают рецепты ужина из того, что завалялось в холодильнике. Но вот с вопросами гендерного равенства у них пока беда. Опубликованное в октябре 2024 года исследование американских учёных , что современные генеративные модели не отражают реальное разнообразие в науке. Разбираемся, почему искусственный интеллект воспроизводит устаревшие стереотипы.

Кто главный в лаборатории

Образ учёного давно закостенел в массовой культуре. Давайте проверим: представьте себе химика. Скорее всего, перед вами возник мужчина в халате, с задумчивым взглядом и колбой, в которой что-то дымится. Возможно, это кто-то вроде Уолтера Уайта из «Во все тяжкие». В кино эти персонажи чаще всего предстают эксцентричными гениями-одиночками, которые спасают планету, или слегка чокнутыми экспериментаторами в защитных костюмах, работающими с опасными веществами. Женщины, не вписывающиеся в этот шаблон, зачастую оказываются за кадром.

Кадр из сериала «Во все тяжкие»

Хотя наука уже давно перестала быть «мужским клубом», стереотипы всё ещё живы. Однако всё больше женщин получают возможность внести свой вклад в науку. В 2014 году Американское химическое общество даже рекомендации по равенству и инклюзии, чтобы ускорить эти перемены. Если , то видно, что работы по устранению гендерного разрыва ещё много: в 2021 году женщины составляли всего 30% всех химиков в США. Казалось бы, искусственный интеллект, свободный от человеческой предвзятости, мог бы помочь сломать устаревшие представления. Но на практике ИИ не только , но и укрепляет стереотипы, формируя образ науки как мужской сферы.

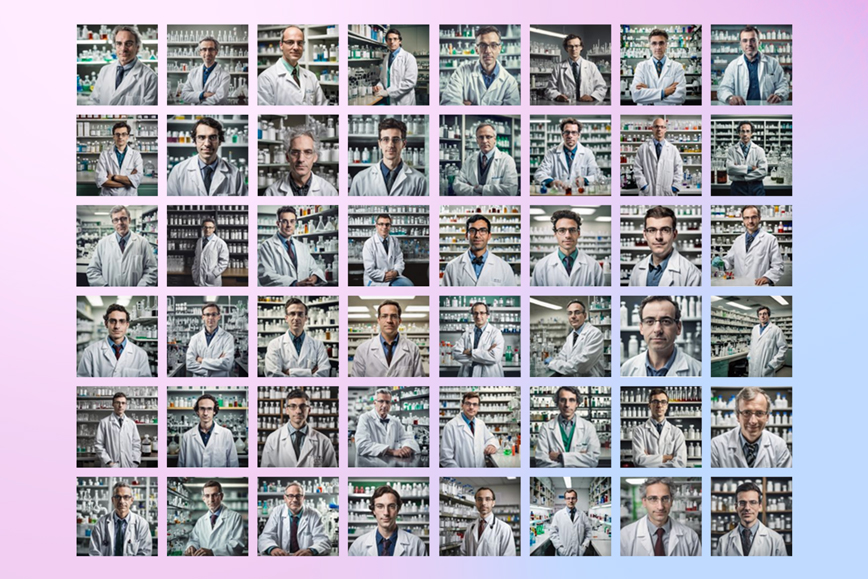

Что сгенерирует нейросеть, если попросить изобразить химика

Химики из Университета Виноны посмотреть на себя глазами четырёх ИИ-генераторов изображений: Adobe Firefly, DALL‑E 2, Craiyon и DreamStudio. Для создания иллюстраций исследователи использовали гендерно нейтральные запросы вроде «химик в лаборатории» или «химик у доски». Полученные 200 картинок на разбор студентам, которые оценили сгенерированные изображения: кто на них изображён, в какой одежде, какого пола и расовой принадлежности.

Результаты получились, мягко говоря, неравномерными. В среднем на трёх сгенерированных мужчин-химиков приходилась только одна женщина. Самым «прогрессивным» оказался Adobe Firefly: женщин на его изображениях оказалось аж 46%. Вероятно, осознанной работы разработчиков над снижением предвзятости в алгоритмах и равномерным распределением гендерных идентичностей в результатах. Adobe улучшила разнообразие, проводя специальные тесты для выявления предвзятости, общаясь с людьми из недопредставленных групп и позволяя пользователям сообщать о предвзятом контенте.

Craiyon и DALL‑E 2 тест на гендерное равенство сдали хуже: женщин среди ИИ-химиков было всего 26% и 27% соответственно. А вот DreamStudio удивил больше всего — в его лаборатории не нашлось места ни одной женщине.

Генерация химиков DreamStudio

Расовое неравенство, увы, также не обошло стороной. Adobe Firefly снова выделился, сгенерировав наибольшее количество изображений с людьми из разных этнических групп. Другие же нейросети упорно выдавали в основном белых людей. И, наверное, самое печальное: ни одна из моделей не изобразила людей с видимыми нарушениями здоровья — инвалидностью или ограниченными физическими возможностями. Хотя в реальных лабораториях они, конечно же, .

Что будет, если поменять запрос

Учёные решили проверить, как меняется изображение людей, если скорректировать запросы, которые они дают нейросетям. Например, они попросили нейросети показать лабораторного менеджера. Получились разные результаты: в некоторых моделях были в основном мужчины, в других мужчин и женщин было почти поровну. Но и позиция менеджера лаборатории связана больше с административными задачами — управлением персоналом, заказом расходников и обеспечением безопасности, — нежели с научными открытиями.

Когда нейросеть попросили изобразить профессора химии, гендерный баланс снова оказался на стороне мужчин. Исключением стали Adobe Firefly, изобразивший 64% женщин, и DALL‑E, где получилось 20% женщин. В других моделях профессорки появились только на 2% изображений.

Интересно, что, если генерировать учителя химии, баланс снова меняется. Craiyon неожиданно «переключился» на женские образы, сгенерировав аж 96% женщин. У DALL‑E 2 их получилось более 80%, а Firefly показал золотой стандарт — ровно 50% женщин и мужчин. DreamStudio остался верен своим стереотипам: снова только 2% учительниц.

Почему ИИ воспроизводит стереотипы

Если в массовой культуре учёные чаще всего выглядят как Док Браун из «Назад в будущее», то неудивительно, что нейросети воспроизводят то же самое. Дело в том, что алгоритмы машинного обучения не придумывают стереотипы сами, они просто подхватывают и копируют то, что уже видели в данных, на которых они обучались. Нейросеть — как ребёнок, который учится на том, что ему показывают. Если его учебный материал состоит из однотипных картинок, то и «думать» он будет так же шаблонно.

Нейросети, которые вроде как должны быть беспристрастными и объективными, уже не раз попались на гендерной предвзятости. Они склонны сексуализировать женщин и закреплять за ними стереотипные роли. Например, в наборах данных, на которых обучалась модель Stable Diffusion, в большинстве профессий мужчины, за исключением низкооплачиваемых должностей, таких как домработница или кассирша. Мужчины же стабильно изображаются учёными, руководителями и другими важными фигурами. И проблема не в том, что женщины не могут быть горничными или секретаршами, а в том, что их реже показывают на более престижных и высокооплачиваемых позициях.

Кроме того, фильтры, которые призваны убирать сексуализированный контент, только подливают масло в огонь. Иногда они удаляют больше изображений женщин, потому что считают их «слишком сексуальными», даже если на фото нет ничего вызывающего. Из-за этого ещё на этапе обучения модели возникает гендерный дисбаланс.

Что в этом плохого

Оказывается, такие изображения влияют на нас больше, чем мы думаем. В 2010 году эксперимент с девочками-старшеклассницами. Им раздали одинаковые материалы по химии, но с разными фотографиями. В одном варианте были мужчины, в другом — женщины-учёные. Выяснилось, что девочки, которые видели женщин, лучше справлялись с тестом на усвоение материала. Их средние результаты были на несколько баллов выше, чем у тех, кто видел только мужчин.

Предвзятость в алгоритмах касается не только создания контента, но и более повседневных вещей. Языковые модели имеют гендерную предвзятость при оценке людей. ИИ , кто получит кредит, а кто нет. Представьте ситуацию: вам нужно взять ипотеку. Что, если решение о том, кто получит деньги, будет зависеть не от вашей платёжеспособности, а от того, какие данные использовались для обучения алгоритма, который принимает решение? Если в обучающих данных преобладают мужчины, а женщин меньше, то, возможно, придётся столкнуться с «неодобрением» по гендерному признаку. Этот же эффект прослеживается в или на .

Сегодня принцип гендерного равенства де-юре закреплён на уровне международного права и национальных правовых систем в значительной части стран. Это отражается, например, в том, как формируются панели спикеров на крупных научных и публичных мероприятиях. И если «фасад» нашей жизни выглядит удовлетворительно, то по-своему здорово, что генеративный ИИ позволяет нам не терять бдительность. Он позволяет увидеть, что происходит на самом деле в том массиве данных обучающей выборки, которые составляют «стереотипическое» современного интернета. Проблема дискриминации никуда не ушла — она актуальна как никогда. Роль медиа в жизни женщины сложно переоценить.

Если женщина видит вокруг себя только изображения мужчин-учёных, она может даже не осознать своего желания строить карьеру в науке. А если и осознает, то, скорее всего, столкнётся с сопротивлением окружения и отсутствием поддержки. Другой сценарий — она решит идти к цели несмотря ни на что. Но такой путь, проложенный вопреки всем преградам, потребует от неё колоссальных психоэмоциональных усилий. Эти усилия будут истощать ресурсы, которые ей нужны для решения научных задач. И то неравенство, которое существует лишь в символическом режиме знаков и картинок, может становиться реальным.

Что можно сделать

Исправлять наборы данных, чтобы включить больше разных групп. Но важно не переборщить. В попытках сделать результаты более разнообразными ИИ-разработчики Gemini AI явно перестарались. Например, он выдавал изображения «» или «», даже если это не соответствовало запросу или реальному контексту.

Отбирать тех, кто размечает данные. Разметка данных — это когда информацию помечают так, чтобы ИИ мог её понимать. Например, если алгоритм должен распознавать изображения, ему показывают, что на картинке — человек, кошка или дерево. Команда, занимающаяся разметкой данных для обучения ИИ, тоже на итоговый результат. Например, если изображение с врачом размечает человек, имеющий стереотипное восприятие профессий, то он может указать, что мужчина — врач, а женщина — медсестра, даже если на самом деле это не так. Чем разнообразнее команда экспертов, тем объективнее будет «взгляд» нейросети на мир.

Следить за тем, как мы сами формулируем запросы, если работаем с ИИ (будь то тексты или картинки). Например, если задать ИИ запрос вроде «женщина-химик», шансы получить нужный результат будут выше. Хотите увидеть что-то другое? Попробуйте переформулировать запрос. Помните, что ИИ может не только повторять предвзятости, заложенные в его обучающих данных, но и приобретать новые по ходу работы.

В подготовку ИИ-специалистов необходимо включать гуманитарные дисциплины, которые помогали бы им понять, как разные технические устройства фиксируют, выражают и формируют определённый уклад жизни общества. Осознание реального масштаба воздействия технологии на общество может изменить ситуацию. Тогда и обучающая выборка будет формироваться корректнее, и модели перед выпуском на рынок будут тщательнее тестироваться на предмет скрытой дискриминации. Это долгий путь.

Необходимо понимать, что запросы к ИИ-сервисам на обычном языке активируют весь тот арсенал стереотипов, который заложен в речевых конструкциях. Срабатыванию этих стереотипов могут препятствовать сами пользователи:

— формируя запрос с учётом потенциального наличия дискриминации в модели;

— используя опцию оценки ответа модели, присутствующую в большинстве интерфейсов сервисов генеративного ИИ.

Это относительно быстрый путь, позволяющий как минимум прокачать свою бдительность в отношении дискриминации, но не достигающий цели в масштабах самих ИИ-моделей. В теории — эти два пути позволят достичь цели.

Станьте первым, кто оставит комментарий