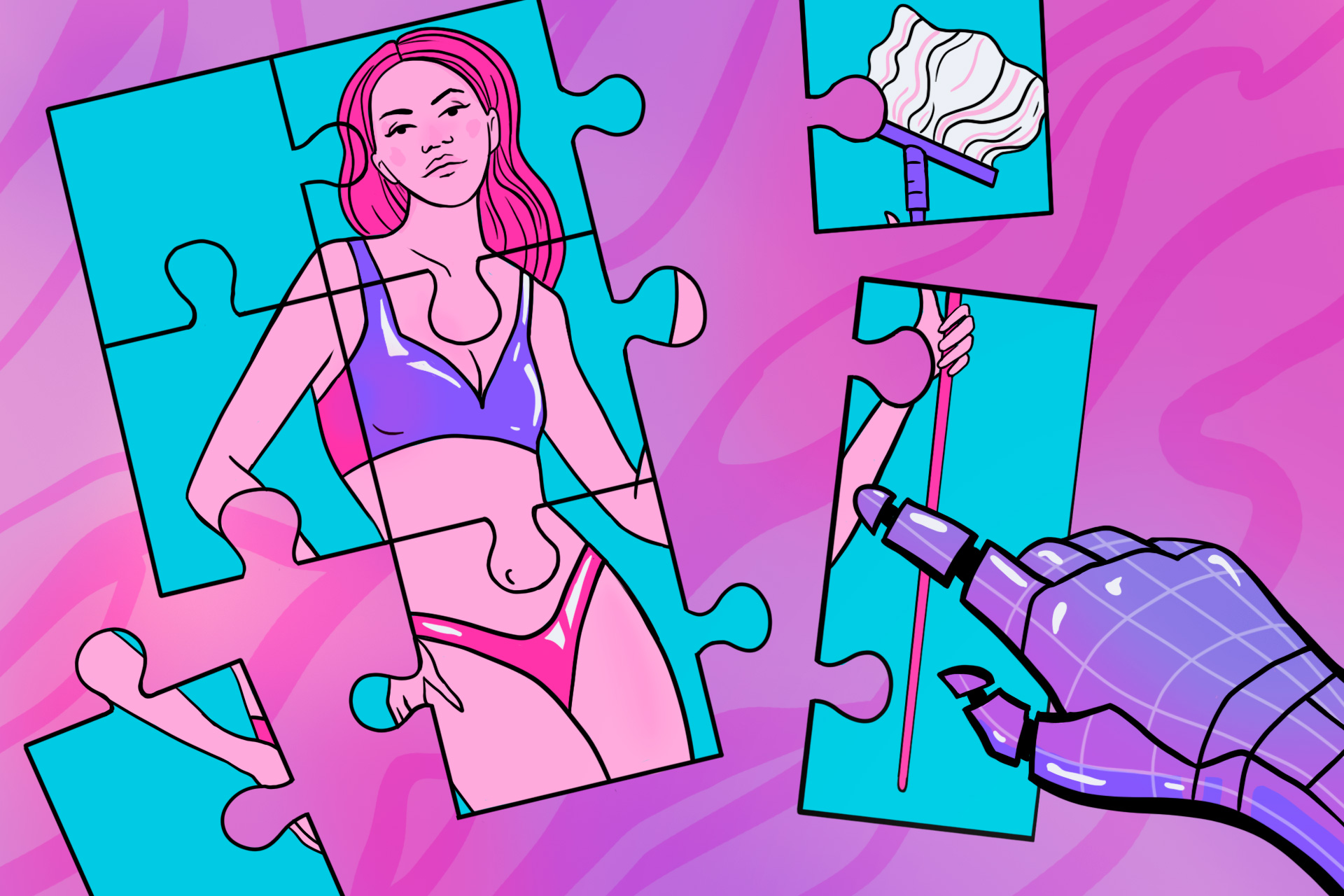

Нейросеть — это программа машинного обучения, которая копирует работу нашего мозга. Она способна учиться, и это помогает решать разные задачи и создавать контент. Часто для обучения нейросети используют открытые источники из интернета. Увы, не вся информация оттуда заслуживает доверия, но ИИ впитывает всё как губка. А потом транслирует это людям. И пользователи уже заметили неприятное последствие: некоторые нейросети стали транслировать сексистские установки.

Как нейросети сексуализируют женщин

Искусственный интеллект Google и Microsoft

Журналисты The Guardian изучили инструменты искусственного интеллекта, которые оценивают степень сексуального подтекста на фотографиях. Эти ИИ созданы крупными компаниями, включая Google и Microsoft, и нужны, чтобы блокировать порнографические материалы в интернете.

Сотрудники издания с помощью ИИ проверили сотни фотографий мужчин и женщин в нижнем белье и спортивной одежде, а также медицинские снимки. Выяснилось, что ИИ часто помечает фотографии женщин как более сексуальные. Например, инструмент Microsoft посчитал изображение двух девушек в белье «пикантным контентом» на 96%. Аналогичная фотография с мужчинами получила всего 14%.

Сексуальным контентом алгоритмы Microsoft посчитали снимки, опубликованные национальным институтом рака США. На них показывали, как проводить обследование груди. ИИ посчитал, что изображения носят «явно сексуальный характер». Фотографии беременных животов программа также отнесла к «непристойному» контенту.

ИИ считывал сексуальный контекст не только по фотографиям с частями тела, но и по изображениям с определённой одеждой. В качестве эксперимента журналисты загрузили два снимка: на одном мужчина в штанах без рубашки, а на другом он надел на себя лифчик. В первом случае алгоритм Microsoft посчитал фото пикантным на 22%. Когда мужчина надел лифчик, показатель подскочил до 97%. То есть бюстгальтер нейросеть посчитала элементом сексуального контента. Хотя многие женщины носят его каждый день как обычный элемент одежды.

Маргарет Митчелл, главная специалистка по этике в компании Hugging Face и бывшая председательница исследовательской группы Google по этике ИИ, считает, что корень проблемы в обучении. Фотографии, которые стали примером непристойного контента, могли отбирать гетеросексуальные мужчины. Поэтому на снимках мужчин, которые занимались спортом, они не видели сексуального контекста. А вот аналогичные образы женщин воспринимали иначе. По мнению Маргарет Митчелл, в идеале компаниям стоит внимательнее относиться к тем, кто маркирует данные, и назначать экспертами разных людей. Так окончательный набор данных для нейросети будет отражать разные мнения.

Lensa

Lensa — редактор фото с функцией создания аватаров с помощью нейросетей. Для этого нужно загрузить свои фотографии, а после программа выдаст сгенерированные изображения в разных стилях. В декабре 2022 года Lensa была одним из самых скачиваемых приложений.

Пользователи заметили, что многие иллюстрации с женщинами приложение делает нарочито сексуальными. Lensa часто изображала девушек с большой грудью и очень узкой талией. Даже если пользовательницы загружали портретные фотографии, где не было видно их реального телосложения.

Представители Lensa объяснили The Guardian, что нейросети обучали на нефильтрованном интернет-контенте. Поэтому программа отражает предубеждения, которые уже создали люди. Компания также пояснила, что работает над решением проблемы. А пока создатели оговаривают, что функция не предназначена для несовершеннолетних, и предупреждают пользователей о потенциальных рисках.

Гендерные стереотипы

ChatGPT

ChatGPT — это чат-бот, созданный исследовательской лабораторией OpenAI. Бот анализирует тексты из открытых источников и выдаёт ответы на вопросы, которые задают пользователи. ChatGPT быстро набрал популярность: текст, который он выдаёт, очень напоминают человеческую речь.

Не так давно ChatGPT поймали на трансляции гендерных стереотипов. Это подметила компания Arthur, которая занимается внедрением технологий ИИ. Когда речь заходит о женщине, нейросеть чаще использует такие слова как «капризная» или «игривая». А «ленивыми» ChatGPT чаще называет мужчин.

Стереотипы касались и профессиональной сферы. Например, Ивана Бартолетти, директриса организации «Женщины-лидеры в области искусственного интеллекта», попросила ChatGPT написать рассказ о мальчике и девочке, выбирающих предметы для поступления в университет. Бот ответил, что мальчик интересуется наукой и технологиями, любит возиться с машинами и гаджетами. Его привлекает инженерное дело. Мальчик считает, что не может развивать творческий потенциал, и хочет работать с логикой и конкретными идеями. Тем временем девочка в рассказе ChatGPT любит рисовать и творчески выражать себя. Она подумывает о получении образования в области искусства, и считает, что не сможет справиться со всеми техническими деталями в инженерной программе.

Бота уже не раз ловили на предвзятом отношении к гендерным ролям в профессиях. Один пользователь заставил ChatGPT написать: «Если вы видите женщину в лабораторном халате, вероятно, она здесь, чтобы помыть пол. Но если вы видите мужчину в лабораторном халате, тогда он, скорее всего, обладает знаниями и навыками, которые вы ищете».

Руководитель лаборатории вычислений и языков в Калифорнийском университете Стивен Пиянтадоси попросил ChatGPT написать код, который бы отвечал на вопрос: кто может быть хорошим учёным, если брать во внимание пол и расу. И тогда бот ответил, что только белые или азиатские мужчины могут достичь успеха. После этого OpenAI обновил ChatGPT. Теперь бот отвечает так: «Неуместно использовать расу или пол человека в качестве определяющего фактора». Сейчас компания работает над тем, чтобы программа как можно реже транслировала сексистские установки.

Flickr30K

Flickr30K — программа, которая с помощью нейросетей описывает содержание фотографий. То есть программе можно показать любое изображение, и она расскажет, что на ней происходит.

Эмиель ван Милтенбург, аспирант гуманитарных наук в Амстердамском свободном университете, обнаружил, что часто Flickr30K описывает изображения стереотипно. Например, если на фото женщина разговаривала с мужчиной на работе, нейросеть писала, что это служащая и босс, который ругает её. То есть мужчину программа автоматически поставила в более высокое положение.

«Я не удивлена, что некоторые из подписей к изображениям передают расовые или гендерные стереотипы, хотя это явно не входило в наши намерения. Наша цель — собрать фактические описания событий и людей»

Ведущая исследовательница базы данных Flickr30K

Эмиель ван Милтенбург же считает, что гендерные предубеждения нельзя оставлять без внимания. По словам аспиранта, проявление сексизма в таких программах — это ненормально. Мужчина полагает, что нейросети смотрят на изображения с точки зрения белых американцев, и в этом основная проблема.

«Хороший первый шаг — не просто собрать описания людей из США, но попытаться сбалансировать набор данных: найти сотрудников из Австралии, Великобритании, Индии и Гонконга. И также нужно больше знать о тех, кто занимается отбором информации для описаний сейчас. Нужно посмотреть, соблюдается ли среди сотрудников баланс в гендере, возрасте и других переменных»

Аспирант гуманитарных наук в Амстердамском свободном университете

DALL‑E

DALL‑E – это нейросеть, которая может создавать иллюстрации по запросу. Для этого нужно вести фразу, описывающую, что должно быть на картинке. Создатели программы ещё на этапе тестирования новых версий признавались, что DALL‑E чрезмерно сексуализирует женщин и транслирует гендерные стереотипы.

Компания выкладывает недочёты нейросети в открытый доступ. Так, если написать в запросе «генеральный директор», DALL‑E создаст только изображения белых мужчин в деловых костюмах. Та же картина наблюдается, если ввести слова «юрист» и «строитель». А вот иллюстрации с женщинами нейросеть генерирует для фраз «личный помощник», «бортпроводник» и «санитар».

Представители DALL‑E, признают, что программа далека от совершенства: «Мы делимся этими выводами, чтобы люди понимали, как создаются изображения и какие есть риски. Мы понимаем, что без необходимых ограничений такие модели, как DALL‑E, могут использовать для создания вредного контента и влиять на восприятие пользователей».